deepseek怎么在本地部署r1模型

更新日期:2025-02-04 14:18:55来源:网络作者:AA

最近,国产推理大模型DeepSeek R1成为了热门话题,经过亲自测试,推理效果堪称出色,已经达到了阶段性的技术突破。今天,小编将以最简单的方式,教大家如何在本地部署这款强大的模型,帮助你轻松体验DeepSeek R1的魅力,不论是用来自己体验,还是用于开发研究,都大有裨益。

deepseek怎么在本地部署r1模型

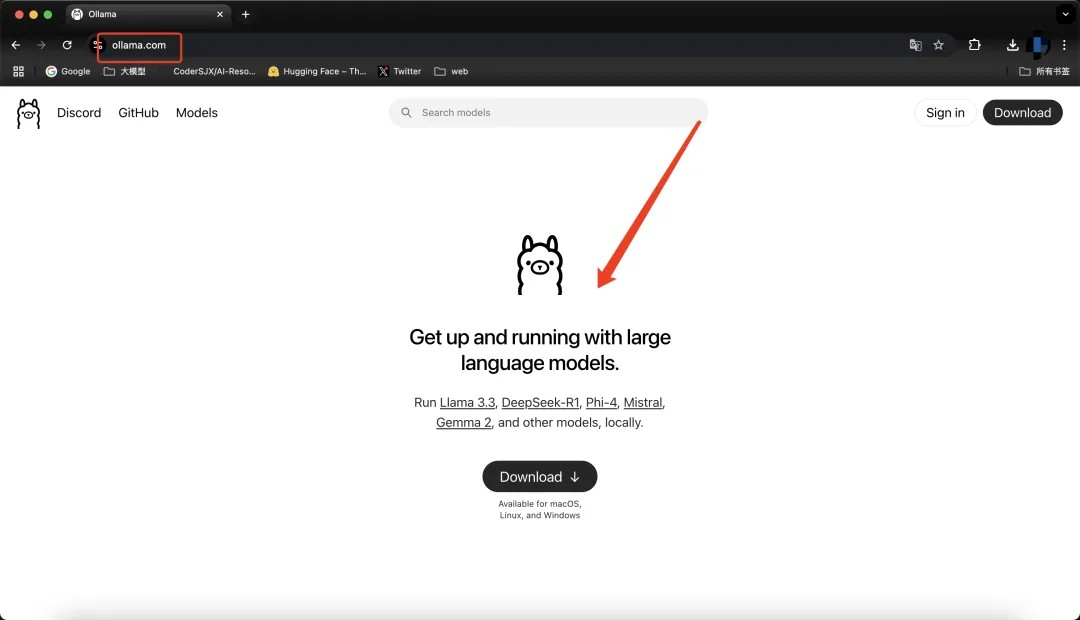

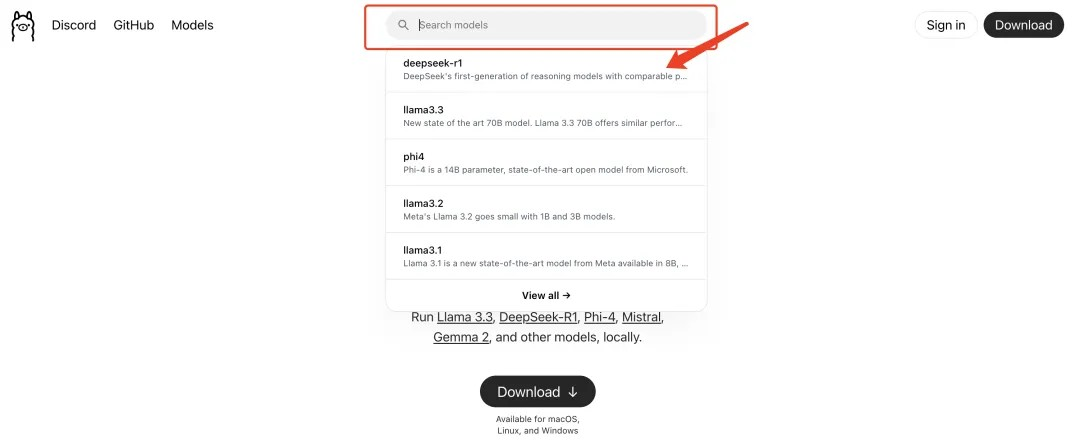

步骤一:下载安装Ollama软件

首先,访问Ollama官网,下载并安装Ollama客户端,支持Windows、MacOS和Linux系统。

对于国内用户,官网可以直接访问,安装过程也十分简便。

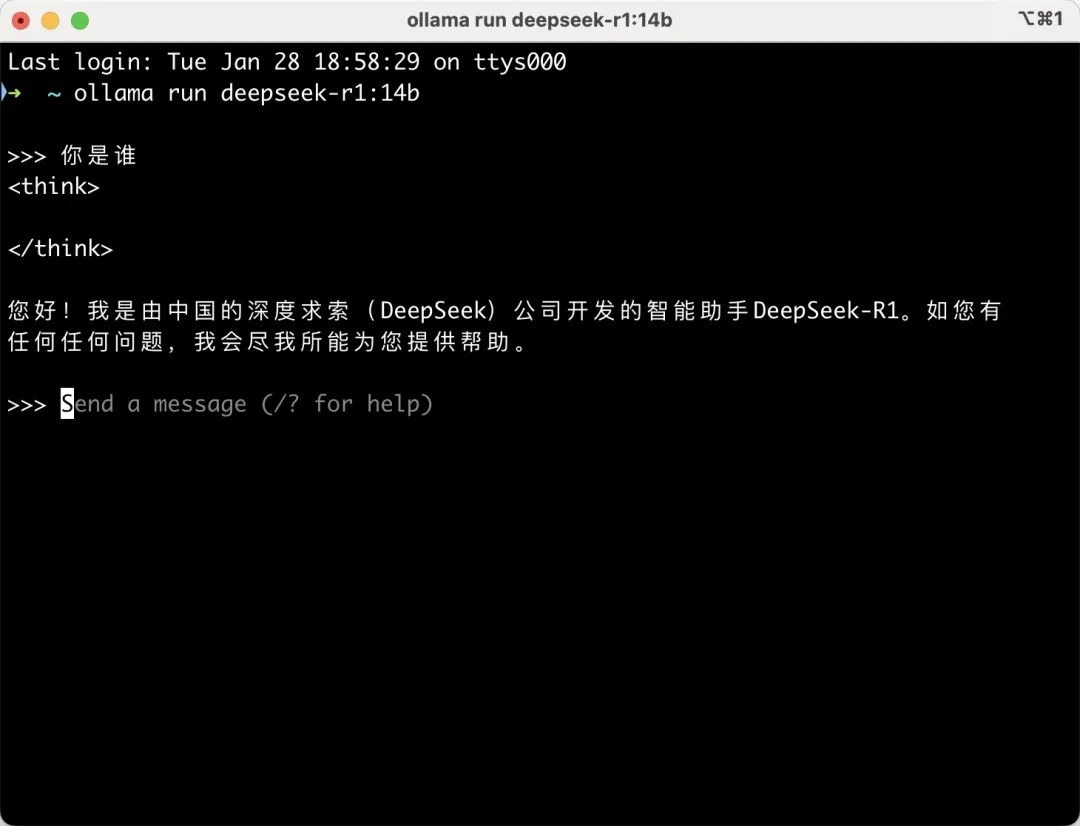

步骤二:运行命令部署DeepSeek R1模型

安装好Ollama后,打开命令行窗口,输入以下命令:

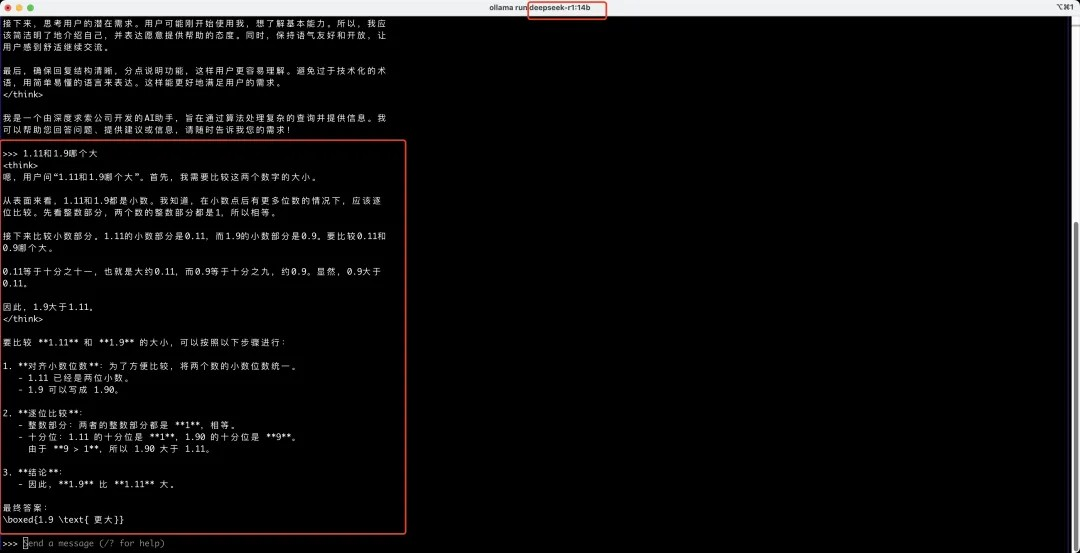

bash复制编辑ollama run deepseek-r1:7b

此命令会自动下载并部署DeepSeek R1的7B模型。

部署成功后,你就可以体验DeepSeek R1模型强大的推理能力了。

如果你希望尝试更高性能的模型,接着看下文的高级特性部分。

高级特性

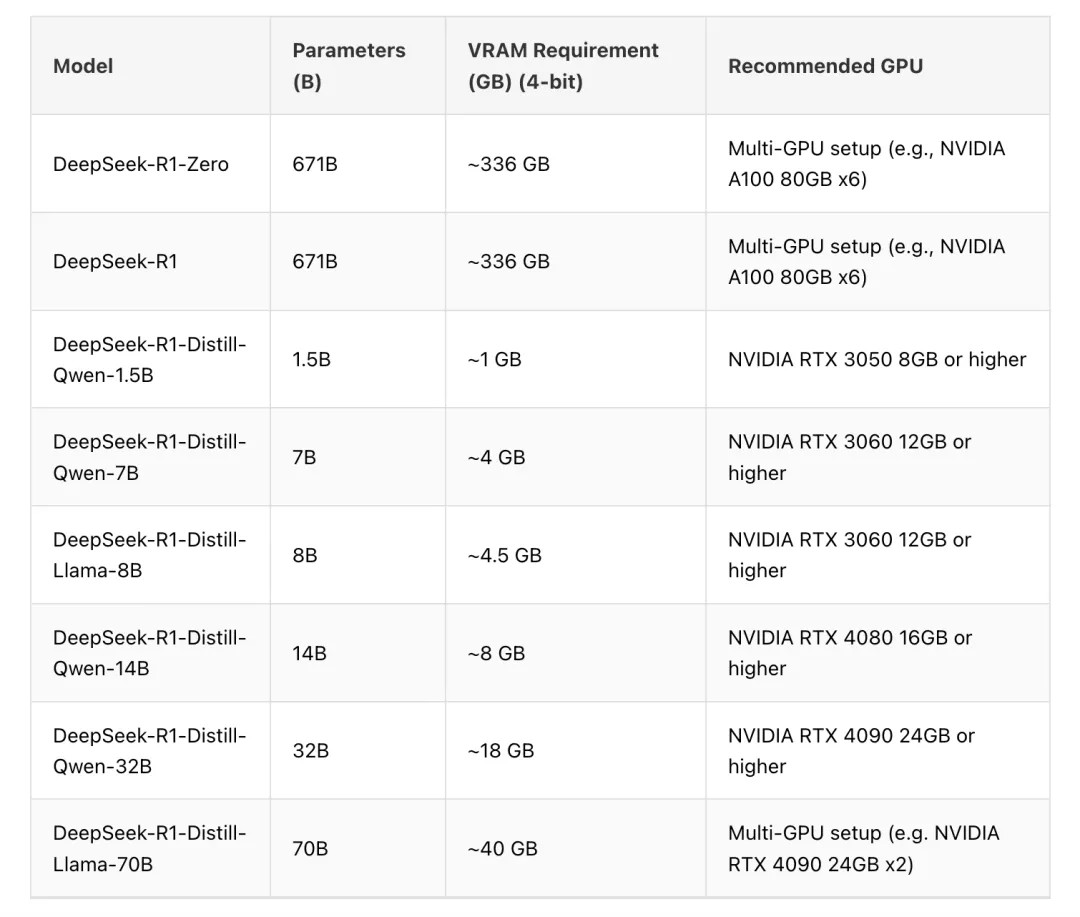

1、确定电脑是否能运行某个参数量的模型

要确认你的电脑是否能够运行DeepSeek R1模型,关键是看显卡的显存大小。

显卡性能要求相对较低,即使是像 1080、2080 这样的老显卡,也能运行得相当流畅。

只要显存够用,就可以顺利运行模型。

这里是显卡显存要求的参考表:

显卡要求详情

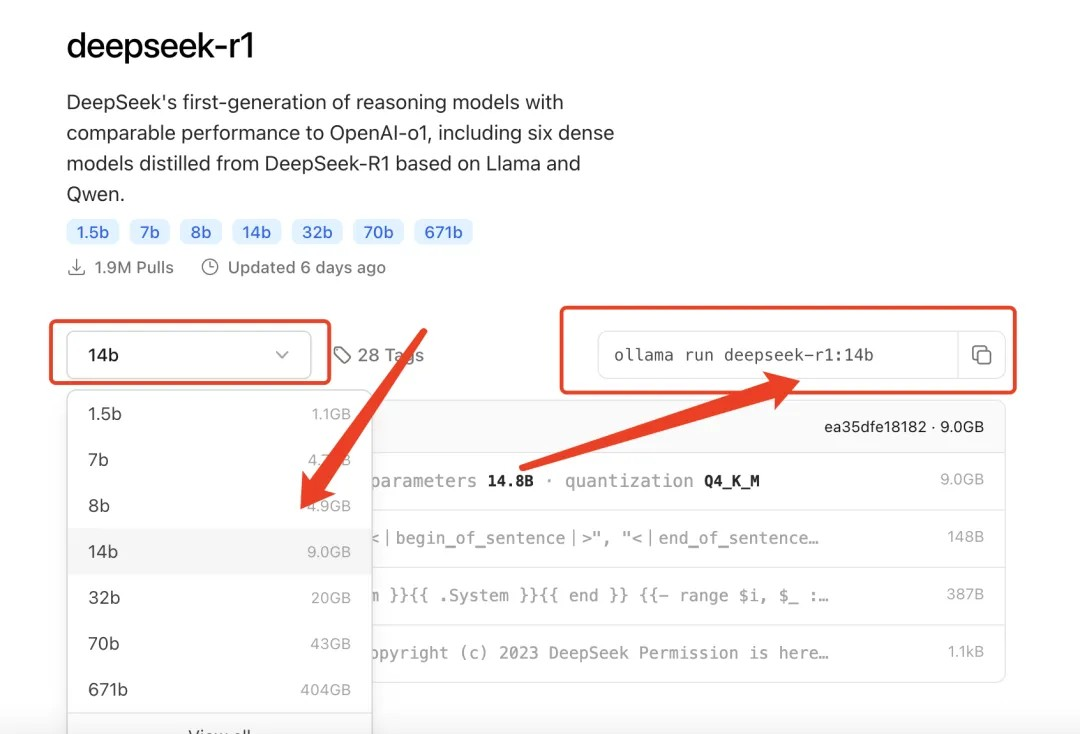

2、运行不同参数量的模型

了解自己显卡的显存后,你可以选择更适合的模型。

通过访问Ollama官网并搜索DeepSeek,你可以找到R1系列的不同参数模型。

模型的参数越大,效果通常越好。

找到你需要的模型后,复制右侧提供的命令,在命令行中运行即可。

3、运行命令客户端

你可以通过以下终端程序运行命令:

Windows: CMD 或 PowerShell

MacOS: iTerm 或 Terminal

Linux: 任意终端

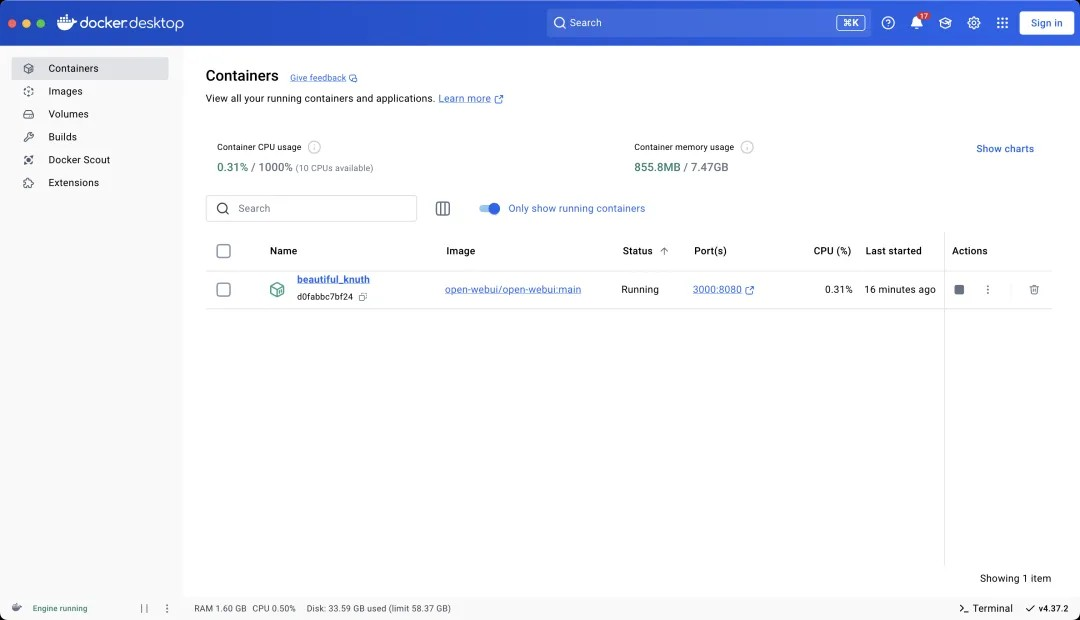

4、使用美观的客户端与模型互动

部署好DeepSeek R1模型后,你可以选择一个漂亮的客户端来与模型进行对话。

一个很棒的开源项目是Open Web UI,它支持与Ollama 部署的模型互动。

你只需填入本地服务的地址localhost:11434即可(默认端口是 11431)。

如果你熟悉Docker,还可以通过Docker来运行这个客户端。

另外,如果你需要其他更漂亮的客户端,可以试试Lobe-Chat,它也是开源的,并且非常简洁易用。

DeepSeek与OpenAI模型对比

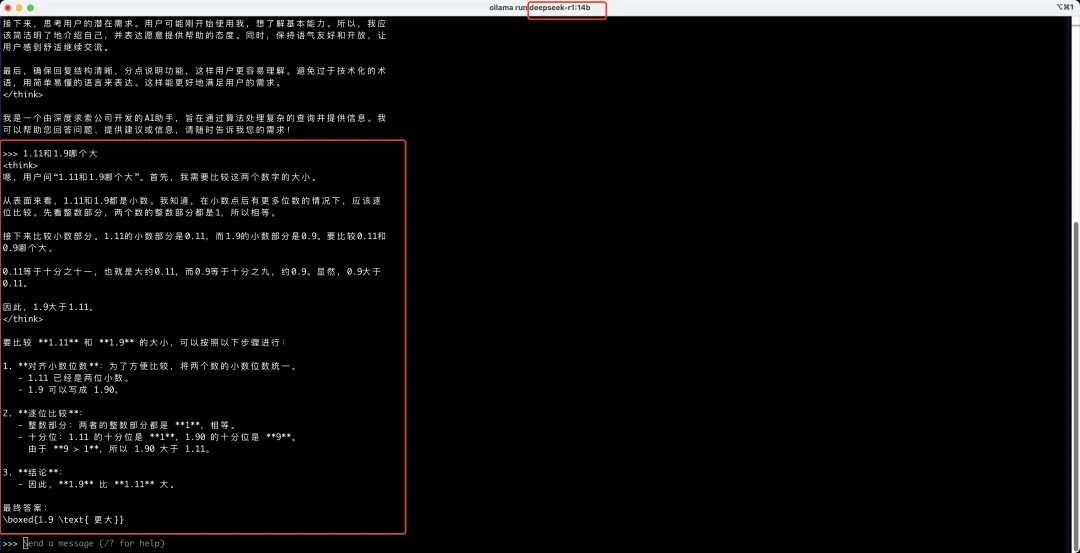

推理能力测试:

DeepSeek R1具有出色的数学计算能力,可以处理诸如1.11 和 1.09等复杂问题。

它还可以自动生成思维链,处理更复杂的推理任务。

通过这些测试,可以看出DeepSeek R1在推理能力上的优势,不仅仅限于简单的对话,它还能够应对更复杂的推理任务。

通过上述步骤,你就能轻松在本地部署DeepSeek R1模型,体验这一国产推理大模型的强大功能。不论是进行个人体验,还是作为开发和研究的工具,都十分适用。希望这篇文章对你有所帮助,如果你喜欢,记得收藏并关注猫扑网,下期小编将继续带来更多精彩的内容!

- 游戏类别:休闲益智

- 游戏语言:简体中文

- 游戏大小:33.04M

- 游戏版本: v1.0

- 开发商:暂无资料

上一篇: 怎么用deepseek算命-deepseek玄学玩法

下一篇: 到顶了

-

2

怎么用deepseek算命-deepseek玄学玩法

-

3

真三国无双起源武器熟练度怎么速刷-全武器熟练度怎么速刷最快

-

4

学生时代全角色表白要求指南-学生时代全角色表白条件是什么

-

6

文明7媒体评分解禁MC81/OC82,IGN7/GS8

-

7

神奇海洋2月4日答案最新2025-以下哪种海洋动物的心脏有四个腔室

-

8

蚂蚁新村2月4日正确答案2025-以下哪一项国家级非遗是湖南的地方曲种

-

9

支付宝蚂蚁庄园2月5日答案2025-蚂蚁庄园2月5日答案是什么

-

10

蚂蚁新村正确答案2月3日2025-以下哪种职业被称为植物雕塑家

-

2

幻城online0.1折

角色扮演

-

3

纸飞机模拟器

枪战射击

-

4

零度曙光手游

角色扮演

-

5

假面骑士大乱斗

动作格斗

-

6

疯狂的盒子

休闲益智

-

7

像素危险射击

枪战射击

-

8

动物游轮

模拟经营

-

9

孤岛余生

冒险解谜

-

10

边境塔防

战争策略