DeepSeek本地部署全流程-DeepSeek本地部署怎么安装

更新日期:2025-02-07 10:06:44来源:网络作者:AA

DeepSeek R1是一款非常厉害的AI推理模型,支持自动推理、联网搜索还有文件处理等功能。虽然网页版使用方便,但由于服务器偶尔不稳定,许多用户更倾向于本地安装运行。今天,小编就来手把手教大家如何在本地部署DeepSeek R1,让AI推理更高效、更流畅!

DeepSeek本地部署全流程

一、网页版使用(适合新手)

如果你不想折腾安装,直接使用网页版是最快捷的方式:

访问官网>>>DeepSeek官网

主要功能

1、深度推理:R1推理模型可自动分析问题并给出逻辑推理结果。

2、联网搜索:支持实时查询最新新闻、资料等内容。

3、文件处理:可解析图片、文档等文件并进行文本分析。

4、但如果你追求更快的响应速度和更稳定的体验,那么本地安装会是更好的选择!

二、本地部署DeepSeek R1

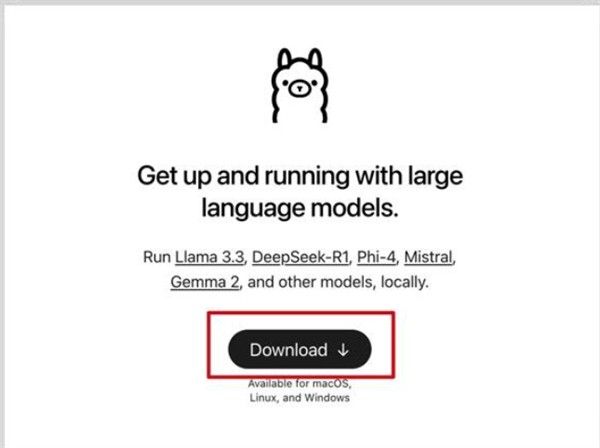

本地运行需要使用Ollama作为AI模型管理工具,以下是详细的安装步骤:

步骤1:安装Ollama

下载Ollama>>>Ollama官网

安装Ollama:

运行安装程序,完成基本安装。

安装成功后,在终端或命令提示符输入:

ollama --version

确保安装正确。

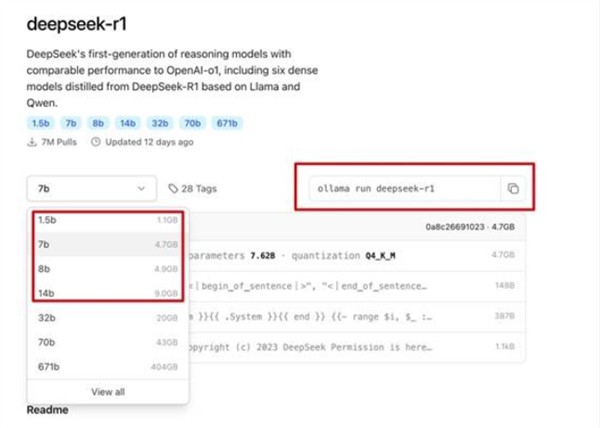

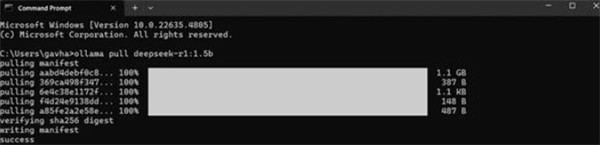

步骤2:安装DeepSeek R1模型

打开终端,输入:

bashCopyEditollama pull deepseek-r1:7b

其中7b代表7B参数规模,你也可以选择1.5b 版本(较小)。

等待下载完成,随后输入:

ollama list

确保模型正确安装。

步骤 3:运行DeepSeek R1

安装完成后,直接在终端输入:

ollama run deepseek-r1

模型启动成功后,你就可以直接在终端输入问题,让AI进行推理了!

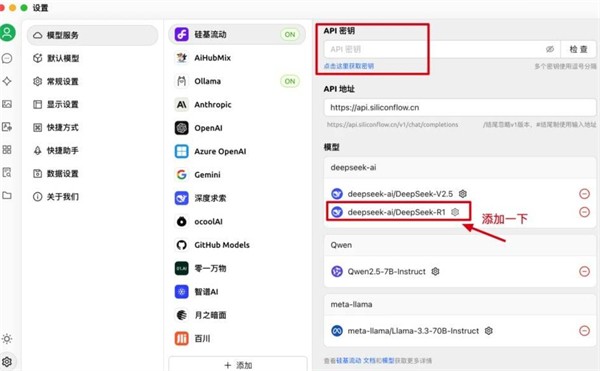

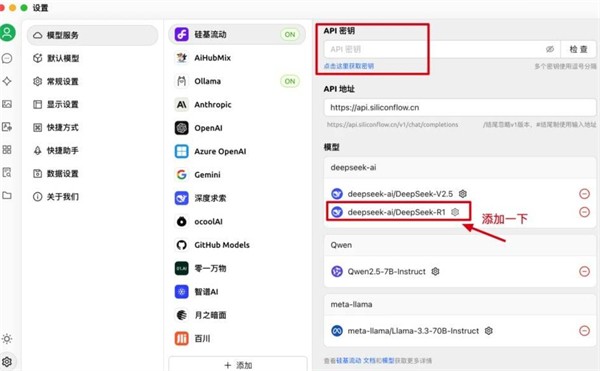

三、使用Cherry Studio进行可视化操作

如果你不想用命令行操作,可以使用Cherry Studio这款客户端,让本地AI模型更易用:

下载Cherry Studio>>>官网地址

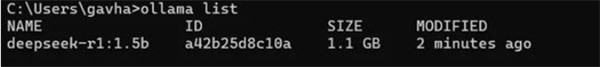

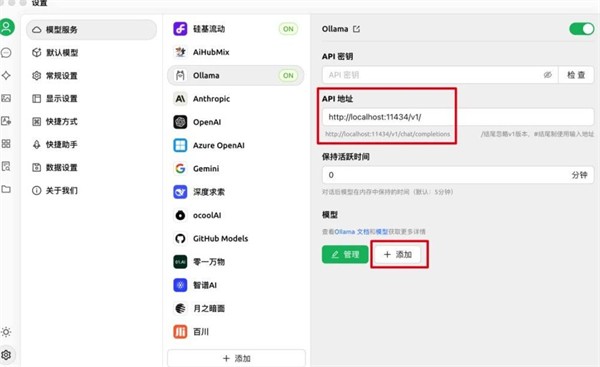

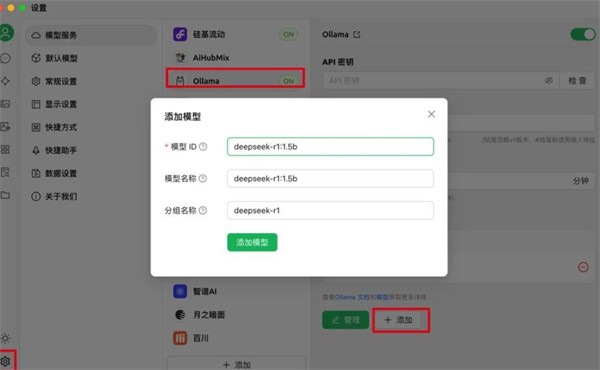

配置Ollama

打开Cherry Studio,进入模型管理。

在API 配置中填写:

API 地址:http://localhost:11434/v1

模型名称:deepseek-r1:7b

开始使用

你可以在Cherry Studio里直接与DeepSeek R1互动,体验更流畅的AI推理。

四、使用云端API(无需本地安装)

如果你的设备性能不足,或不想本地部署,也可以使用第三方API:

硅基流动(Silicon Flow)

官网:>>>点击进入

提供免费API Key,注册后可直接使用。

OpenRouter免费API

访问OpenRouter平台,寻找DeepSeek R1 API进行调用。

在Cherry Studio 或其他支持API的应用中填入API Key,即可远程调用AI进行推理。

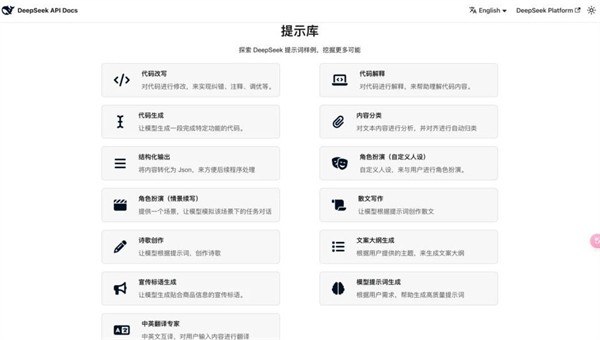

五、提示词库推荐

官方提供了各式各样的提示词库,帮助你更精准地指引AI任务:>>>提示词库入口

示例提示词

美食教学

“你是专业大厨,请帮我写一道详细的美食制作教程,包括食材、步骤和注意事项。”

产品分析

“作为产品经理,请帮我分析一个新产品的市场需求,并设计一个App 原型。”

通过以上方法,你就能顺利在本地部署和使用DeepSeek R1,甚至还能用API云端调用,让 AI 助力你的日常工作!

更多软件最新教程就在猫扑网

- 游戏类别:休闲益智

- 游戏语言:简体中文

- 游戏大小:33.04M

- 游戏版本: v1.0

- 开发商:暂无资料

-

2

文明7游戏全领袖能力强度排行榜-文明7领袖能力解析

-

3

最终幻想7重生pc版好感度对话选项选择建议

-

4

天国拯救2撬锁技巧-天国拯救2怎么开启上锁的箱子和门

-

5

天国拯救2键鼠操作表-天国拯救2游戏键鼠操作说明

-

6

DeepSeek本地部署全流程-DeepSeek本地部署怎么安装

-

7

神奇海洋2月7日答案最新2025-以下哪种海豹因为浓密而粗硬的胡须而得名

-

8

蚂蚁新村2月7日答题答案2025-以下哪种职业群体被称为体育赛事的幕后气氛组

-

9

支付宝蚂蚁庄园2月8日答案2025-小鸡庄园2月8日答案最新

-

10

天国拯救2铁锹怎么获得-天国拯救2铁锹位置

-

2

空闲火车帝国大亨

模拟经营

-

3

houseflipper房产达人2

模拟经营

-

4

登山赛车二

体育竞技

-

5

幸运召唤师

战争策略

-

6

房产达人家居设计

模拟经营

-

7

英灵神殿大乱斗

动作格斗

-

8

猫咪滑块

休闲益智

-

9

倒水大师手游

休闲益智

-

10

xutry

音乐舞蹈